无泄漏液冷散热器

CoolestDC | 案例研究

可持续数据中心的未来 - 无泄漏液冷散热器可减少碳足迹和能源消耗

CoolestDC 推出可高度定制的无泄漏服务器内液体冷却解决方案,利用 EOS增材制造 技术加速绿色数据中心计划。

在过去几年里,由于对云应用、数字化、物联网设备以及 4G 和 5G 边缘计算的需求不断增长,数据中心行业得到了蓬勃发展。据 IDC* 预测,到 2025 年,全球数据量将达到 175 ZB。此外,数据中心的总投资预计将从2019年的2447.4亿美元增至2025年的4321.4亿美元,复合年增长率(CAGR)为9.9%。但是,随着数据的持续增长,数据中心对环境的影响问题也需要得到解决。去碳化是一个关键因素,因为它使可持续发展目标和可再生能源成为关注焦点。其中一个主要目标就是利用高能效冷却解决方案,打造更具可持续性的数据中心运营。在机架密度、电力成本和可持续发展活动的推动下,直接到芯片的液体冷却可能成为主要的冷却方法。

挑战

寻找一种替代钎焊和组装冷板的方法,最大限度地降低直接对芯片液体冷却应用中的泄漏风险,以缩小机架密度、降低电力成本并提高可持续性。

由于数据中心运营商更熟悉冷冻水和直接膨胀系统,因此风冷散热器目前在该领域占据主导地位。然而,就风冷散热器的总能效和潜在节能效果而言,其耗电量和碳排放量是有限的,因为目前风冷数据中心的大部分耗电量是由空气冷却器造成的。鉴于更严格的可持续发展目标和针对数据中心所有者的新碳税的引入,直接液体冷却最终可能成为数据中心运营商采用的主要冷却技术。目前,直接液体冷却还只是一种利基活动,只适用于具有特殊基础设施或保修的高性能服务器。液体冷却散热器进入市场的主要障碍之一是潜在的泄漏风险,这可能会导致服务器受损。超大规模 DC 的所有者、运营商和服务器原始设备制造商目前都在探索部署无泄漏直接液体冷却解决方案的可能性,以满足对更高机架密度的需求,同时提高总能效。

"淡马锡基金会很高兴能支持CoolestDC开发一种颠覆性的、高能效、低耗水的数据中心冷却解决方案。由于该解决方案既可以部署在棕地,也可以部署在绿地应用中,这一创新可以成为可持续数据中心运营的蓝图,使新加坡等城市成为绿色数据中心枢纽"。

淡马锡基金会首席执行官林克泉

解决方案

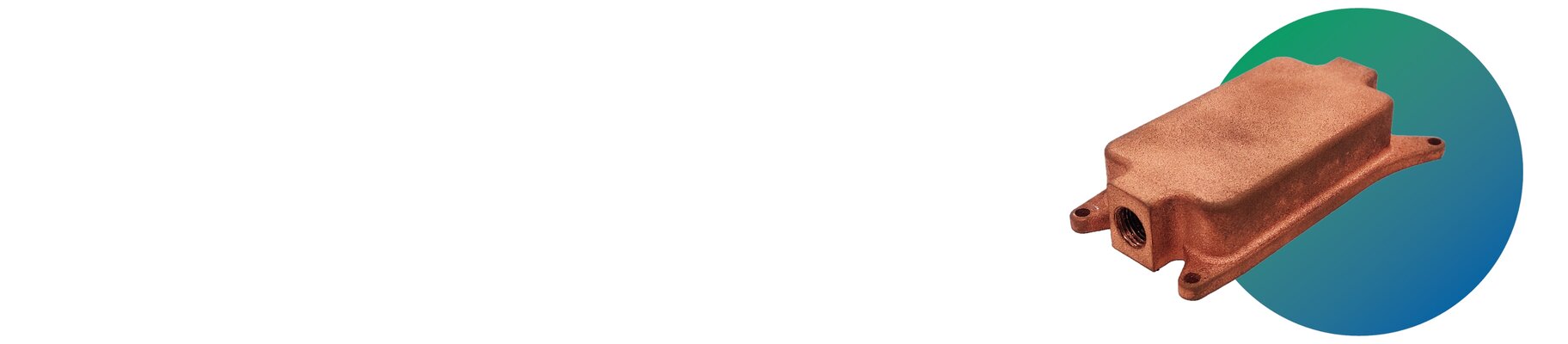

利用 EOS DMLS 技术和高密度EOS Copper CuCP 工艺,我们开发并制造了无泄漏、无垫片、无接头的一体式冷板,从而创造出完全无泄漏的服务器内液体冷却解决方案。

EOS 最新的增材制造 (AM)技术使 CoolestDC 能够设计和制造一体化、无泄漏的一体式液体冷却散热器,以满足工业界的关切和要求。利用 AMCM M 2901kW 系统和经过验证的EOS Copper CuCP工艺(基于商业纯铜),我们制造出了高密度铜散热器,可承受 6 bar 及以上的水压,且无接头、组件或垫片。此外,AM 工艺用途广泛,能够生产薄壁内部结构(0.2 毫米及以上),而获得专利的斜鳍片则是采用优化工艺打印 而成。

的专利斜鳍片采用优化工艺打印,以保持其精度和高分辨率特征。这种一体化制造工艺不仅解决并消除了可能导致服务器电路板灾难性故障的泄漏问题,还大大降低了制造复杂性(无需组装和钎焊),从而延长了部件的使用寿命。

"以新加坡为例,我们正在测试液体冷却技术。我们与新加坡国立大学旗下一家名为 CoolestDC 的本地公司进行了试点,他们正在使用与机器学习或人工智能相关的服务器,以降低其功率密度。使用 CoolestDC 的液体和两相冷却解决方案,数据中心的总能耗最多可节省 30%。与此相关的是二氧化碳排放量和耗水量的显著减少。

Digital Realty 亚太区董事总经理 Mark Smith

成果

- 无泄漏一体式冷板,可承受 6 巴及以上的水压。

- 减少资本性支出(CAPEX)投资,因为不同服务器板的工具成本为零。

- 可自由设计和制造大规模定制的板厚、翅片密度和位置。

CoolestDC 的一体式 AM 冷板在属于 Digital Realty 的一个全面运行的主机托管设施中与业界领先的风冷散热器进行了对比测试。测试结果如下

- CPU 芯片和内核温度降低 10 °C(图 1)

- GPU 的工作温度显著降低近 50%(图 2)

- GPU 能够以高出 40% 的时钟速度满负荷运行,且无节流现象(图 2)

- PUE 降至 1.2(计算值)

液冷散热器与传统风冷散热器相比的优势

| 参数 | 风冷散热器 1U 服务器 |

水冷散热器 (AM 一体式机身) |

|---|---|---|

| 满负荷时的 CPUTdie | 90 °C 节流 | 46.0 °C |

| 图形处理器满负荷运行时的性能 | 1 750 MHz 节流 节流 5.8 TFlops |

2 450 MHz 8.1 TFlops |

| PUE | 1.4 | 1.23 可通过 LCCRD 实现 |

| 渗漏问题 | - | 无泄漏(无接头和垫片) |

对数据中心提供商和利益相关方的益处

根据上述 GPU 性能,一个满载 25 台 1U 服务器(配备 4 个 GPU 的高性能计算服务器)的液冷机架可产生 810 TFlops 的性能。要达到同样的性能,需要 30 台风冷服务器,而且必须分成两个机架,每个机架有 15 台服务器,否则就会超过风冷机架 15 千瓦的最大容量。因此,我们估计为最终用户节省的价值主张和总成本如下:

数据中心客户使用案例和方案的估计总体拥有成本(成本节约

CoolestDC 与 EOS Additive Minds 团队合作,开发了以 AM 为中心的设计,以进一步优化产品性能,并将制造成本降低 50% 以上。目前,我们还在探索数字化工作流程,以更好地支持和加快冷板的大规模定制,满足不同客户的需求。使用 AM 技术,大规模定制冷板无需模具成本,客户也不需要最低订货量。如果采用传统制造方法(机械加工、电火花线切割和钎焊等),每个新 CPU 和 GPU 型号的最低设置成本约为 3K。这种 AM 解决方案适用于绿地和棕地应用,包括边缘计算。我们预计,下一代设计将更具成本效益和效率,从而为最终用户节省更多成本并提高性能。

公司简介:

CoolestDC 是一家总部位于新加坡的深度技术初创企业,在高热通量电子产品的热管理方面拥有丰富的专业知识,并能利用 Oblique Fin 高效液体冷却技术提供设计服务。CoolestDC 目前与 EOS 新加坡 Additive Minds 团队合作,提供创新的增材制造 冷却解决方案,帮助推动数据中心的可持续发展。更多信息:https://www.coolestdc.com

EOS 案例研究

通过 EOS 探索三十年来开拓3D 打印 的卓越成就